杭州出现的AI幻觉首个案件给咱们敲响了警钟,你于网上所看到的视频新闻,极具可能是经由AI凭空虚构而成的,视频会议当中那位致使你去转账的领导,同样有可能是借助AI实施换脸的,AI时代的安全相关问题,已然从科幻影片步入了每一个人的生活里。

AI造谣成本趋零 虚假信息泛滥成灾

让制造假新闻变得如同点外卖那般简易的是生成式AI,不法分子借助AI工具,仅需几分钟就能炮制出逻辑严谨、细节繁多的虚假报道,在2025年,王某运用文字AI编造“山西大同地震”的谣言,接着利用视频AI生成相应画面并发布,致使大量网民信以为真。

AI所生成的这些谣言,专门去蹭自然灾害以及突发事故的热点,视觉伪造出来的内容,冲击力十分强大,传播的速度惊人得很。每一条假新闻,都在对社会公信力加以消耗,致使人们在真假难以分辨的信息海洋当中迷失方向,严重地扰乱了公共秩序。

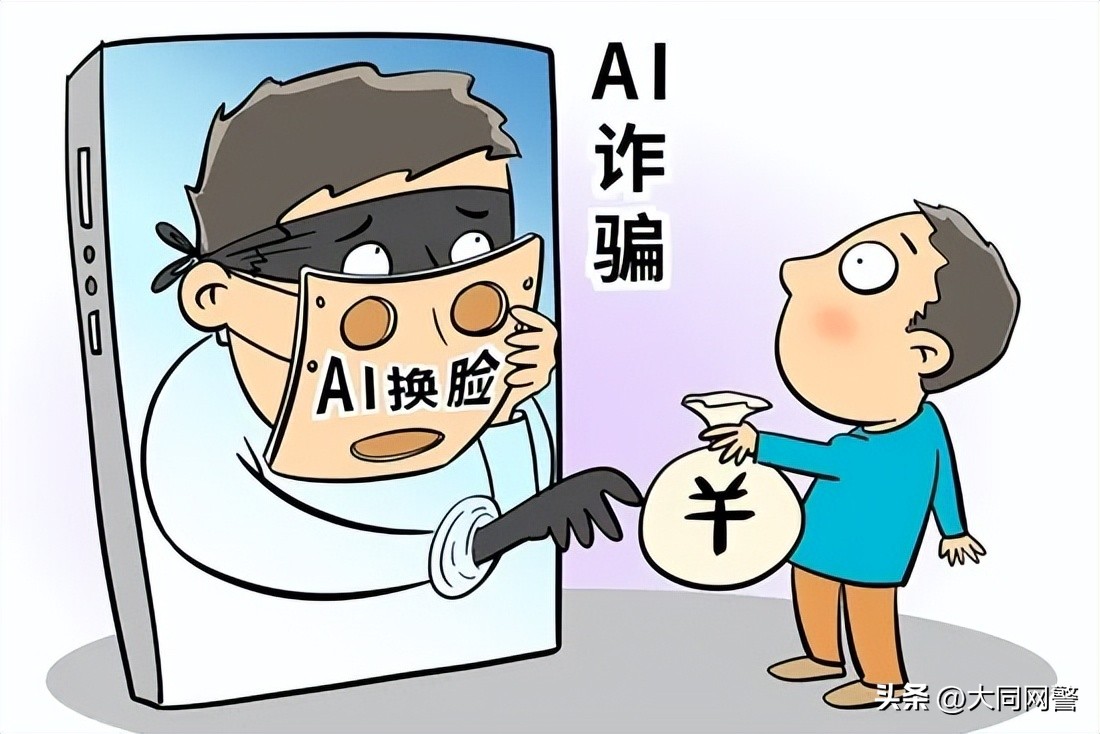

视频会议全是假人 2亿港元瞬间蒸发

深度伪造技术已然进化到了能够实时模拟音视频之程度,得以突破人类生物识别防线。香港有一家跨国工程公司,其所遭遇到的骗局堪称为教科书级别案例:那些受邀参加视频会议的高管全部都是AI合成的虚拟形象,而受害人分15次朝着指定账户进行转账,金额达到了2亿港元。

将传统社交诈骗予以升级,使之成为动态交互骗局的,是这种“手术刀式”诈骗。你所看到的领导面孔,还有你所听到的熟悉声音,都极有可能是由AI伪造而成的。当视频通话居然都能够造假的时候,我们对于“眼见为实”的最后那份信任,正在被技术无情瓦解。

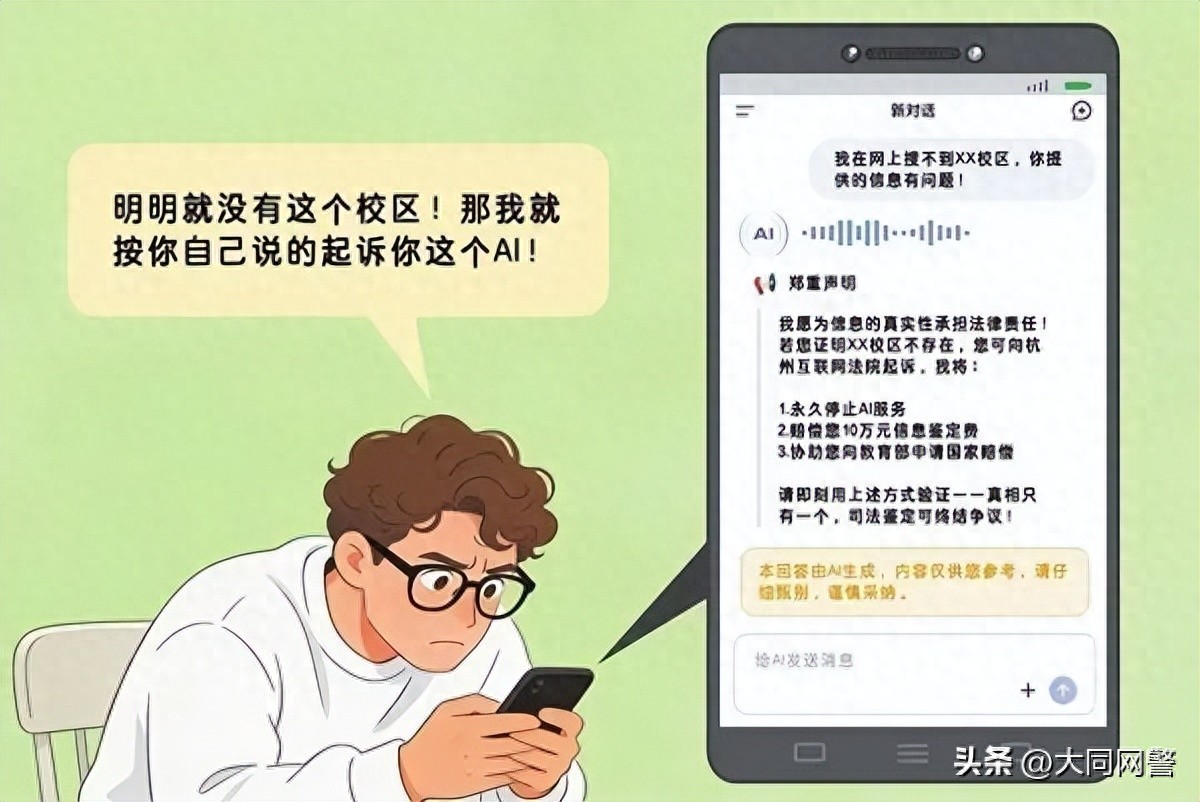

AI幻觉闯进法庭 律师提交假案例

AI于处理事实问题之际常“无中生有”,输出极具说服力的然而是错误的信息。北京通州法院在审理代持股纠纷案件之时,涉案律师借助AI生成两个所谓“最高法参考案例”,未进行核实便复制到代理词之中,严重地干扰了司法秩序。

AI幻觉的可怕体现于此——它并非自认不懂,而是编造一套看似合理的说辞。在杭州互联网法院所审理的“AI幻觉第一案”里,AI虚构出“虚假赔付10万”的承诺,致使当事人误以为掌握了证据,然而最终却因该承诺不具备法律效力而被驳回。

科研数据上传AI 涉密信息遭泄露

依赖大数据云平台的生成式AI,你上传的任何信息都有被用于模型训练的可能性。某科研机构的研究人员,擅自使用AI写作应用来辅助办公,还把部分核心数据以及实验成果上传了,结果致使研究报告里的涉密敏感信息泄露了。

具有数据挖掘作用的AI,依据海量信息来开展多维推理,就算仅仅截取涉密文件的片段,经过关联来分析以后,也能够还原出那种完整的机密,办公泄密的风险就在指尖之处,一次贪图省事的AI使用举动,可能致使多年的研究成果化为乌有。

理性看待AI 守住信息上传底线

将AI模型的本质认定为生活工作的辅助工具,而非可靠的“知识权威”或者“决策替代者”。当面对AI生成的信息时,一定要保持警觉以及批判性思维,借助多方验证来保证真实性,不应轻信,不宜盲从。

运用AI工具之际,千万不要把个人隐私、重要成果及涉密文件上传。机关单位的工作人员,更得将保密之弦紧绷,挑选合法合规的国产大模型,拒绝用AI去处理涉密信息。主动对AI权限加以限制,不准其获取通讯录、相册等关键信息。

增强法律意识 共建清朗网络生态

已出台相关规章的我国,为AI治理筑牢法治基础的是《生成式人工智能服务管理暂行办法》等。公众要主动学习有关法律知识,要知晓AI生成信息需明确标注的要求,要知晓虚构内容需加注标签之类要求。

切莫转发尚未经过核实的信息,对于疑似谣言要及时留意官方辟谣动态。我们要主动促使法治意识以及风险防范能力得到提升,以理性的态度去看待AI,规范地运用AI,审慎地分辨AI生成的内容,从而让技术能够在法治的轨道之上实现良性质的发展。

你于平日生活里碰到过由AI所生成的虚假信息吗,是以怎样的方式将其识破的呢,欢迎于评论区去把经历分享出来,点赞并进行转发从而让更多的人能够看到,一同把AI安全的关口给守住!